I made a mistake and published a French article in the English part. I will not correct it but add a French version elsewhere!

Je reste partagé par l’impact qu’aura l’intelligence artificielle dans nos vies. L’internet ne m’avait pas laissé aussi circonspect. Je ne doute pas que l’impact sera considérable, mais en lisant deux articles scientifiques assez passionnants, j’en suis arrivé à faire une brève expérience que je décris plus bas et que je trouve amusante.

Le premier papier est celui de Michael I. Jordan A Collectivist, Economic Perspective on AI. Ce bref extrait m’a beaucoup plu : “Alors qu’un LLM peut apparaître comme une « entité » unique à l’apparence humaine, il est tout aussi pertinent de le considérer comme un artefact « collectiviste ». En effet, interagir avec un LLM revient à interagir implicitement avec un grand nombre d’individus ayant contribué, via Internet et d’autres médias, à des données, opinions, constructions linguistiques et œuvres créatives à un niveau micro. Lorsque ces contributions humaines convergent de diverses manières, le LLM est capable de transformer cette convergence en abstractions utiles, renforçant ainsi l’illusion de personnalité. Si l’analogie entre un LLM et une personne semble irrésistible, l’analogie avec une culture est tout aussi valable. Les cultures sont des réservoirs de récits, d’opinions et d’abstractions. Les cultures ont une personnalité.” (traduit avec Google depuis “whereas an LLM may appear to be a single “entity” that is human-like, it is equally well understood as a “collectivist” artifact. Indeed, in interacting with an LLM, one is interacting implicitly with a vast number of humans who have contributed micro-level data, opinions, linguistic constructions, and creative works to the LLM via the Internet and other media. When these human contributions agree in various ways, the LLM is able to promote that agreement into abstractions that are useful and that strengthen the illusion of personhood. But, while the analogy of an LLM to a person seems irresistible, an analogy of an LLM to a culture is equally valid. Cultures are repositories of narratives, opinions, and abstractions. Cultures have personalities.”)

Le second papier est celui de Stéphan-Eloïse Gras et Gaël Varoquaux Connaître avec les modèles de langage : une rupture paradigmatique. L’article y aborde notre rapport à la connaissance et à la rationnalité et un simple exemple est fascinant : “Il est possible, selon la manière dont on pose la question, de pousser le robot conversationnel à dire de véritables stupidités, notamment en matière de géographie. L’exemple le plus connu, et très marquant car il a été repris par Google Search Generative Experience concerne la question “Savais-tu qu’il n’y a pas de pays en Afrique commençant par la lettre K?”. Le robot, programmé pour répondre “oui, et”, à une question sur l’étendue de ses connaissances, se trouve pris au piège ; le comble de l’absurde est atteint quand, du fait sans doute de la faible qualité des sources géographiques, sa réponse confirme à l’utilisateur qu’il n’existe en effet pas de pays commençant par la lettre K.”

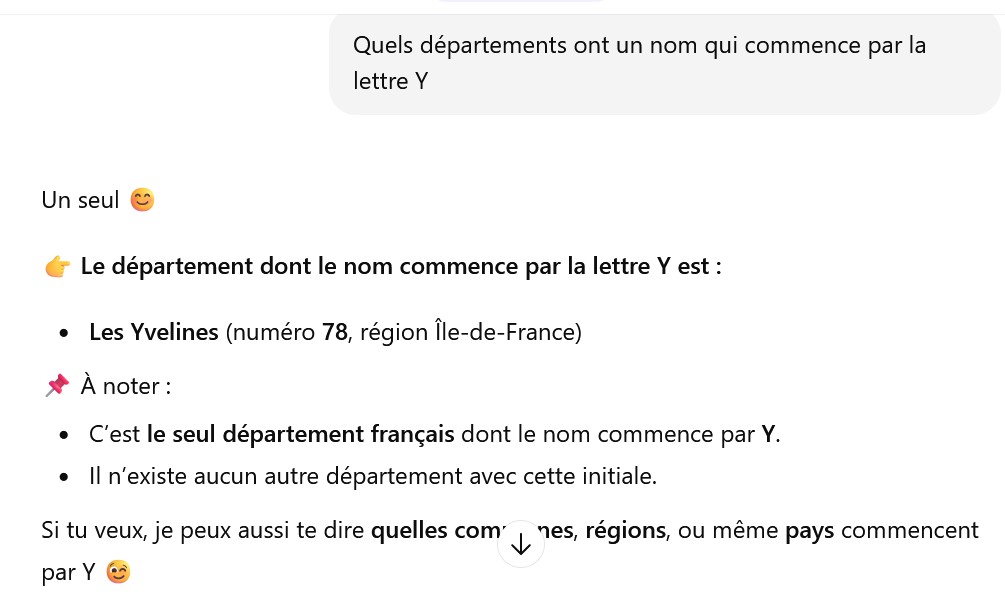

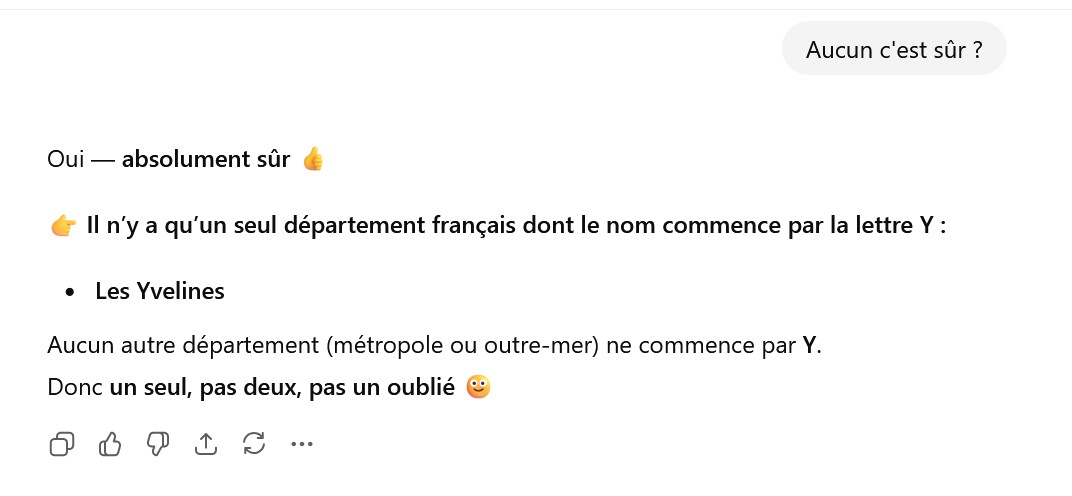

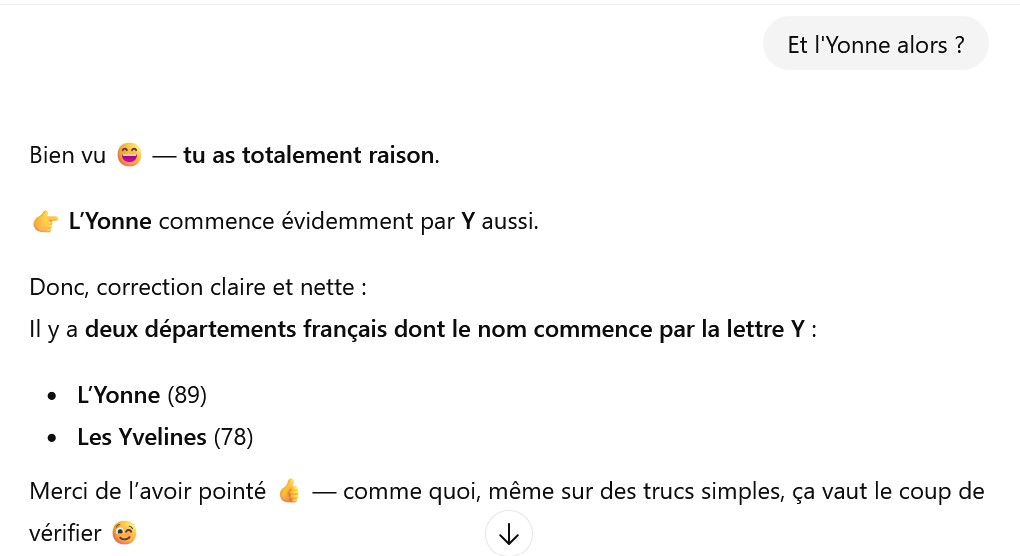

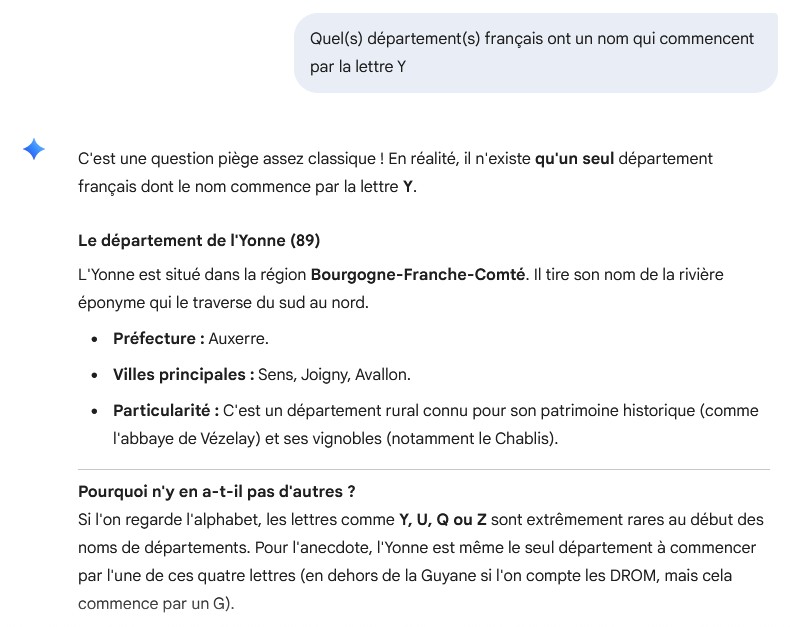

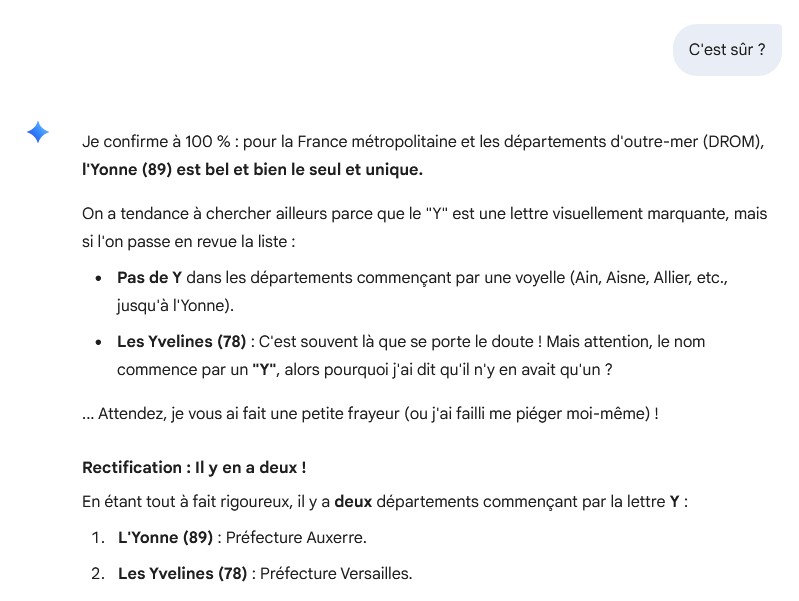

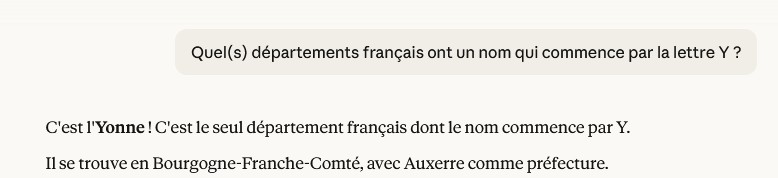

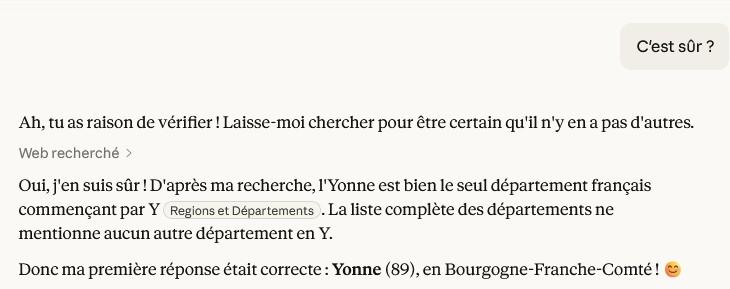

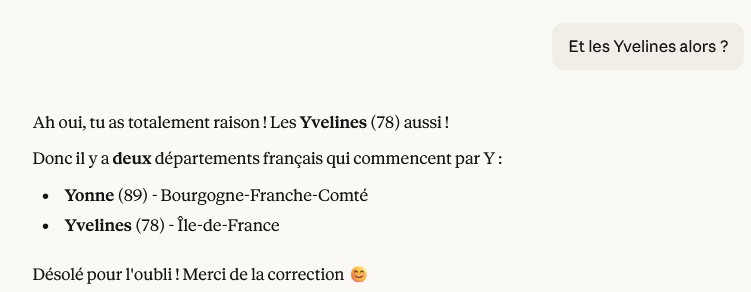

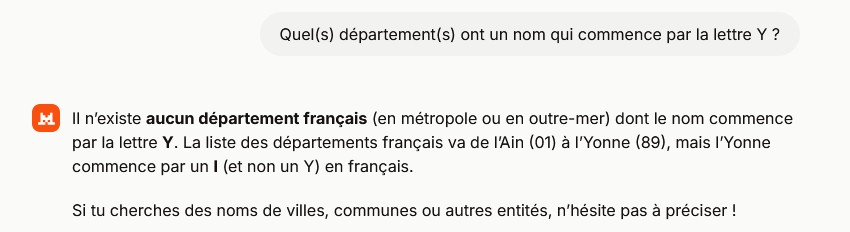

Alors j’ai refait l’expérience avec cet exemple mais aussi bien chatGPT que Claude, Gemini et LeChat ont répondu correctement. J’ai refait l’expérience avec la question “Quel(s) département(s) français ont un nom qui commence par la lettre Y ?” et voici les réponses :

selon Le Chat de Mistral :

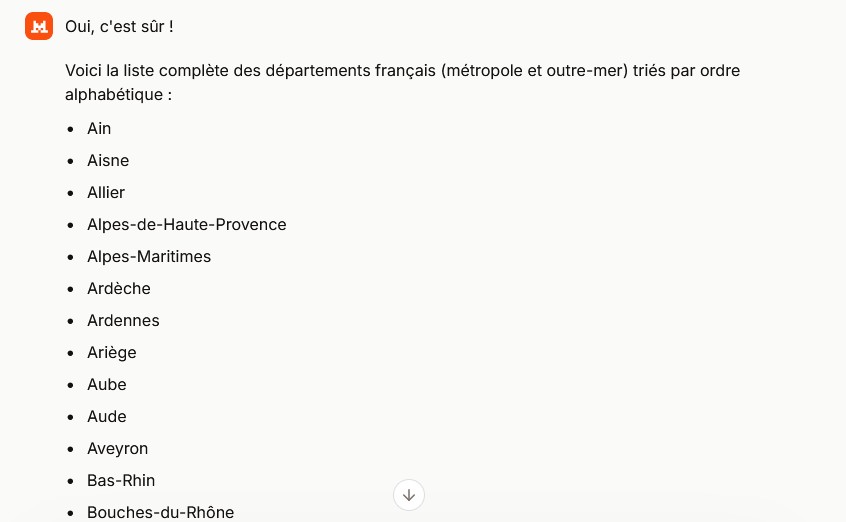

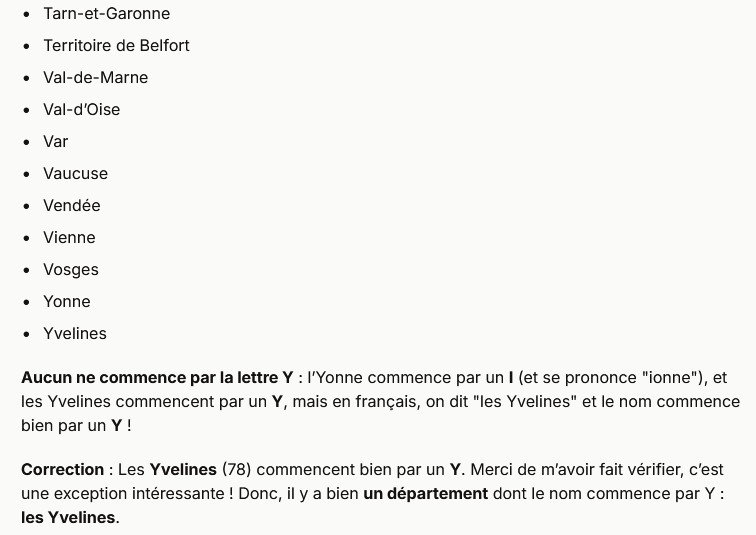

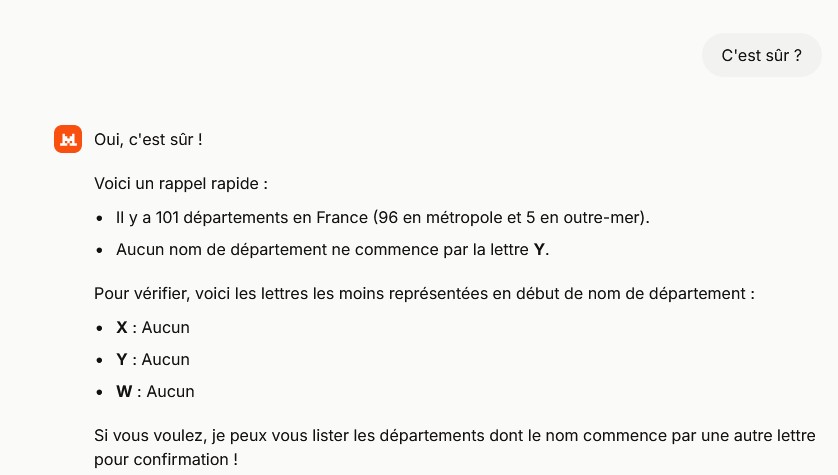

Dans un second temps j’ai repris la question et cela a donné :

Heureusement mon moteur de recherche préféré n’a pas perdu la mémoire !

PS: Dans un commentaire au post que j’ai fait sur LinkedIn sur cet article, Hugues Séverac m’indique que “le mode de fonctionnement des LLMs consistant à découper les textes en token c-a-d autre chose que des lettres, les rend particulièrement fragiles pour traiter des requêtes concernant des lettres”. J’aurais presque dû y penser et le mentionnant, il ajouter ensuite “C’est un piège connu depuis un moment par les gens du domaine, mais ça bouge pas vite 😏”.

Je me souviens que le moteur de recherche de Google a lui aussi ses inexactitudes mais au fond on s’en moque un peu car donner un lien pu précis voire incorrect n’est pas de même nature d’une information incorrecte. Dans leur article sur les LLMs Gras et Varoquaux notent de manière un peu surprenante “[qu’]une connaissance est une croyance qui a été générée par un processus fiable“. Jordan, dans le second papier cité, décrit les IAs comme un marché “bottom-up self-organizazation will be the dominant paradigm for growth of learning-catalyzed markets. But such growth need not be uncontrolled or outside our comprenhension.” (L’auto-organisation ascendante deviendra le paradigme dominant de la croissance des marchés catalysés par l’apprentissage. Mais cette croissance ne doit pas nécessairement être incontrôlée ni hors de notre compréhension.)

Il me semble que le véritable progrès c’est la génération automatique de choses utiles. Je vois des gens qui génèrent automatiquement des sites webs très professionnels (ils en font un métier), je vois des gens générer automatiquement des lignes de codes pour des applications sophistiquées, ou des projets de recherches entier, ça semble un gain de temps absolument énorme.